Zuerst danke für die Screenshots. Ich dachte, die Fehlermeldungen sind mit der Wahl von RGB32 weg. Scheinbar dann doch nicht. Ich sehe auch, dass du den MPEG-Codec gar nicht konfigurieren kannst.

Wie du schon schreibst, unterstützt Hauppauge nur 2 Codecs. Probiere einmal „No recompression: UYVY“ aus, ob du da irgendwas einstellen kannst. Die Werte bei „custom video format“ stimmen. Sehe gerade, dass bei der alten Version 1.19.11 der Button „Pixel Format“ fehlt. Dann muss man vermutlich diese Einstellungen mit den verschiedenen Filtern in VDub machen.

Video/Filter:

Für RGB32:

Filter Convert format: 32-bit RGB, das ist nicht anders zu machen, es wird nur die Datei etwas größer.

Für Rec. 601:

Filter RGBConvert: BT.601, Full Range YCbCr.

Das ist nur ein Vorschlag, ob das so passt, weiß ich nicht. Das könnte man aber mit Mediainfo überprüfen. Ich vermute aber, dass trotzdem nicht gecaptured wird. No recompression: UYVY ausprobieren.

Sollte das nicht klappen, dann ganz normal ohne Filter capturen. Dann die AVI-Datei in VDub2 importieren und den BM SD 8 bit 4:2:2-Codec auswählen. Auf „Pixel Format“ klicken, dann kann man RGB24, Rec. 601 und Full range (0-255) einstellen.

Laut dem Bild „AVI Info“ wird ja korrekt mit dem MJPEG-Codec gecaptured.

Eine 20 Jahre alte Hauppauge-Karte ist schon lange nicht mehr empfehlenswert. Man muss bedenken, dass die elektronischen Bauteile ebenfalls schon so alt sind. Solche Karten überhaupt noch zu kaufen, ist reiner Quatsch. Es ist ja wirklich kein moderner Codec auswählbar. Die Hauppauge-Karte ist ein besserer Grabber mit dem MPEG-Codec. Ist aber heutzutage technisch nicht mehr zeitgemäß.

Ja, der "Desktop Video Installer v12.9.msi" ist in Ordnung.

Virenscanner bei Videobearbeitung immer abschalten. Am besten deinstallieren und uBlock Origin installieren. Normalerweise reicht der Windows Defender völlig aus, es sei denn du besuchst chinesische oder russische Seiten.

Set Custom Format:

Ja, normalerweise ist YUV 4:2:2 interleaved korrekt. Das habe ich noch nicht ausprobiert. Es kann aber sein, dass dann VDub nicht captured. Du kannst das ja einmal so belassen, aber bei „Pixel Format“ RGB24 auswählen. Das könnte klappen.

Die Einstellungen bei „Capture Device angeschlossen“ stimmen.

Dass du nicht lange suchen musst, lade ich dir die Datei „gradation.vdf“ hier hoch.

gradation.zip

In den Ordner plugins einfügen, nicht in plugins32.

Lagarith empfehle ich dir nicht, da der Codec für eine Videobearbeitung mit einem Schnittsystem recodiert werden muss.

Lagarith basiert auf MPEG-Kompression mit Delta Frames. Hat eine GOP-Struktur (I, B und P-Frames). Ob Edius den richtigen Schnittpunkt findet, weiß ich nicht. Mitten in einer GOP-Reihenfolge zu schneiden, wäre technischer Pfusch. Huffyuv wäre besser.

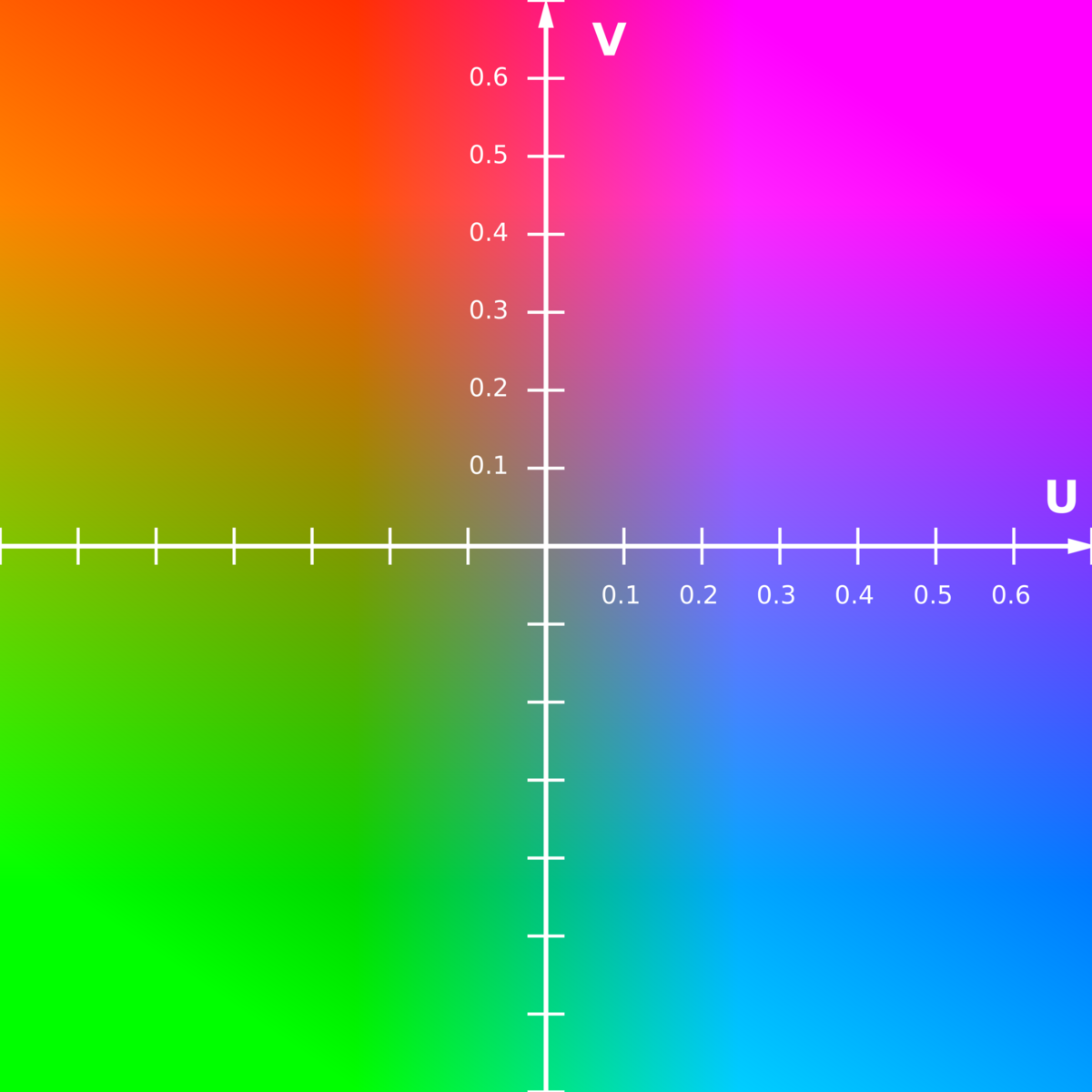

YUV und RGB-Filter:

In VDub gibt es verschiedene Filter. Einige sind in YUV und andere sind in RGB. Man sollte häufiges konvertieren vermeiden und Filter mit YUV und Filter mit RGB einzeln zusammenfassen. Das erkläre ich dir, wenn du eine Filterliste erstellt hast.

Wie du die Gradation curves einstellen musst, erkläre ich dir später, wenn das Capturen funktioniert.

Technisch ist der Blackmagic SD 8bit 4:2:2-Codec besser als der MJPEG. Beide Codecs sind zwar in 4:2:2, aber der Blackmagic SD 8bit 4:2:2-Codec hat eine wesentlich höhere Bitrate als der MJPEG. Der MJPEG hat eine Bitrate von ca. 46.000 Kbps und der 4:2:2-Codec eine Bitrate von 165.000 Kbps. Das ist ein Vorteil bei schnellen Bewegungen, wie diese z. Bsp. bei Fußballspielen auftreten. Und ist nicht auf komprimierte MPEG-Basis, sondern wirklich unkomprimierter Codec.

Gruß

Joachim